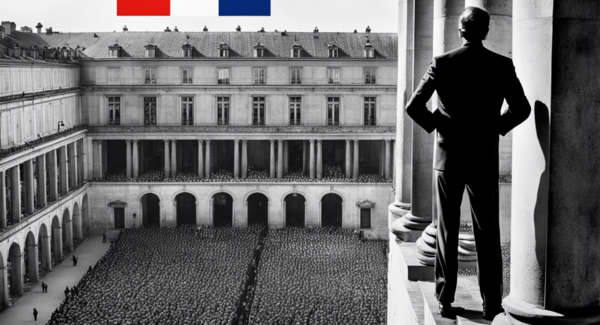

L’IA et la surveillance : les dangers de l’enfermement progressif !

Publié par Yannick Chatelain, le 18 avril 2023 1.2k

Par CHATELAIN YANNICK Professeur Associé chez GRENOBLE ECOLE DE MANAGEMENT GEMinsights Content Manager, Chercheur Associé à la chaire DOS

L’IA au service de l’humanité : quelles sont les dérives à éviter ?

Au niveau des entreprises, certains présenteront l’IA comme une aide au service des utilisateurs. Sous un autre angle, cette « aide » peut être considérée comme un enfermement progressif de l’usager en fonction de ses utilisations d’internet, des réseaux sociaux, etc. Pour reprendre les propos de Paul Watzlawik (École de Palo Alto), des algorithmes que je qualifierai d’enfermement proposent « toujours plus de la même chose » pour « toujours plus du même résultat » et transforment progressivement l’Internet de l’usager lambda, non pas en une porte-fenêtre grande ouverte sur le monde mais en un judas renforçant ses croyances et sa vision du monde bien loin de l’ouverture sur ce dernier.

Se pose alors la question du libre arbitre, de la vie privée ; un souci qui n’est certes pas d’ordre algorithmique, l’important étant (pour certains) la récupération de la data, et tendre ainsi vers le Graal : le marketing prédictif. À titre d’exemple, la Française des jeux a testé pendant trois mois un logiciel d’analyse du visage évaluant si les utilisateurs sont majeurs, a indiqué mercredi 5 avril un responsable de la start-up Yoti (membre du Laboratoire pour la protection de l’enfance mis en place par l’Élysée en novembre). Dans quel cadre légal se fait cette expérimentation à l’insu des consommateurs ? Je ne le sais pas. Notons toutefois que Florian Chevoppe-Verdier, en charge de la politique publique chez Yoti, a reconnu que le système n’était pas infaillible : « par exemple, une vie dans la rue vieillit prématurément le visage ».

C’est pourquoi au Royaume-Uni, où cette solution est utilisée dans des hypermarchés pour l’achat d’alcool, Yoti a refusé d’évaluer l’âge des migrants. Un aveu de faiblesse ? Vous avez dit discrimination ? Fiabilité discutable ? L’enfer est toujours pavé de bonnes intentions. Dans le contexte du contrôle des individus, il me semble que cette voie soit de plus en plus encombrée par des intérêts commerciaux.

L’IA au service de notre humanité ?

En ce qui concerne les États, sous de nombreux aspects, usages et applications, l’IA est également vendue à la population comme étant la panacée.

Or, une majorité de la population est ignorante des méta-analyses relatives à la vidéosurveillance et ne peut que croire dans le mythe de l’efficacité proposée par les pouvoirs publics sous des prétextes sécuritaires. La surveillance augmentée algorithmique dédouane de leurs responsabilités les personnes en charge de la sécurité des citoyens. Le « technosolutionnisme » poussé à son paroxysme sans moyens humains est à la fois inutile et non fiable. J’en veux pour preuve la tragédie de Nice, la ville alors la plus vidéo-surveillée de façon traditionnelle...

Retrouvez l'article complet sur Contrepoints

Photo credit: AZRainman on Visualhunt