Fête de la science 2024 - Eric Blayo, un océan de calculs

Publié par Echosciences Grenoble, le 11 juin 2024 1.9k

A l'occasion de la Journée mondiale de l'océan, rencontre avec le chercheur grenoblois Eric Blayo, ambassadeur de la Région Auvergne-Rhône-Alpes pour la Fête de la science 2024, entre océan, mathématiques et modèles numériques.

Eric Blayo est enseignant-chercheur en mathématiques appliquées à l’Université Grenoble Alpes, directeur adjoint du Laboratoire Jean Kuntzmann (LJK) et membre de l'équipe AIRSEA au LJK et à Inria. Il est spécialiste de modélisation numérique de l’océan et du climat. Attaché au partage des connaissances, il est un des membres fondateurs de l’association “La Grange des Maths” dont il est le vice-président. Avec générosité et simplicité, il a accepté de répondre à nos questions.

Quel est votre parcours ?

J’ai passé mon enfance à Saint-Malo, ce qui explique sans doute mon attrait pour la thématique des océans ! Après les classes préparatoires à Rennes, je voulais continuer les mathématiques. J’avais alors le choix entre une école à Paris et l'École nationale supérieure d'informatique et de mathématiques appliquées (Ensimag) à Grenoble. L’équipe de handball universitaire de Grenoble était alors championne de France, ça m’a aidé à choisir (rires). Je suis resté à l’Ensimag de 1985 à 1988 et j’y ai découvert les mathématiques appliquées.

J’ai réalisé des stages dans des services de recherche et développement qui m’ont plu et un DEA de maths appliquées. Je voulais poursuivre en thèse. A l’époque, on ne pouvait pas choisir son laboratoire facilement en ligne. Il y avait des affiches à l’Ensimag, dont une de l’Ifremer (1). Je leur ai téléphoné et ils m’ont donné des noms de personnes travaillant à l'Institut de Mécanique de Grenoble, dont Christian Le Provost, océanographe spécialiste des marées et précurseur de la modélisation numérique de l’océan (2).

J’ai réalisé ma thèse dans l'équipe d'océanographie fondée par Christian. Ça a été l’occasion d’apprendre sur le tas cette discipline, pour moi qui venait des maths appliquées. A la fin des années 1980, un modèle numérique n’avait pas grand chose à voir avec ce qu’on fait maintenant. Ma thèse portait sur le développement de ces modèles, pour arriver à quelque chose de plus réaliste, par exemple simuler l’Atlantique nord.

J’ai réalisé ma thèse en 4 ans, puis un post-doctorat de 2 ans et enfin, j’ai été recruté comme Maître de conférences au Laboratoire de modélisation et calcul [ndlr : qui deviendra le Laboratoire Jean Kuntzmann]. L’équipe de Jacques Blum sur les mathématiques pour la physique et l’environnement venait alors de se créer, en partenariat avec l’Inria qui venait de s’installer.

Grenoble ne se distingue pas particulièrement par sa proximité avec l’océan ! Pourquoi y a-t-il des océanographes dans la capitale des Alpes ?

Grenoble a toujours été très bonne en mécanique des fluides à travers son passé tourné vers la Houille blanche. Il existait à l’époque l'Institut de Mécanique de Grenoble, dont a dérivé le LEGI (Laboratoire des Écoulements Géophysiques et Industriels).

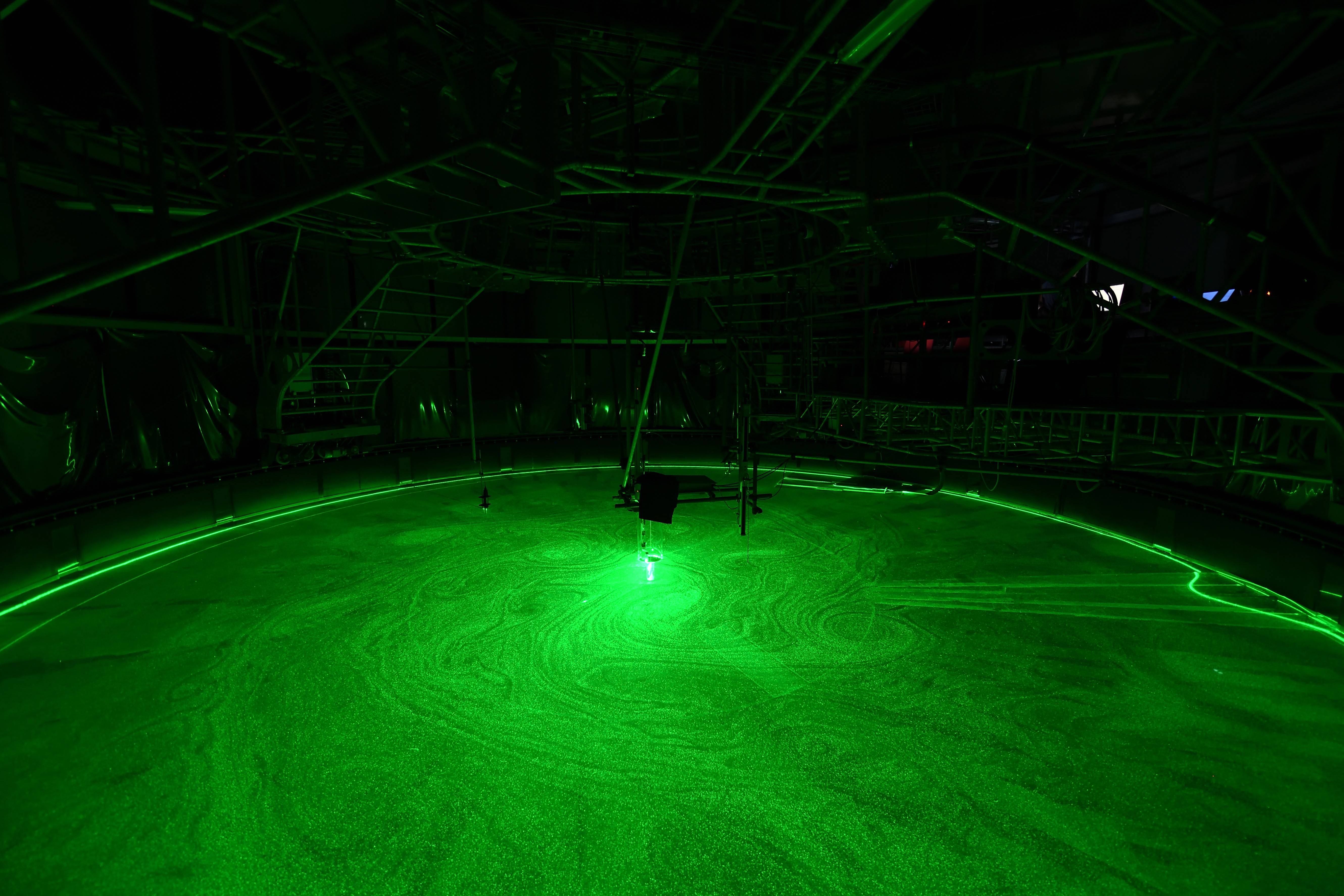

Le passage à l’océanographie s’est fait via la plateforme tournante Coriolis, créée en 1960 sur la Presqu’île scientifique pour étudier les effets de la construction du barrage et de l’usine marémotrice de La Rance (3).

Expérience dans la plateforme Coriolis moderne (crédit : LEGI)

Le projet initial, gigantesque, consistait à fermer la baie du Mont Saint-Michel par un barrage de 40 km et 800 turbines. Comme la marée est dépendante des reliefs des côtes et des fonds marins, il y a eu à l’époque l’idée de réaliser un modèle réduit de la Manche afin d’anticiper les conséquences de la construction d’un barrage et donc de la modification de la forme de la côte.

Quelle est la différence entre les mathématiques “classiques” et les maths appliquées ?

Les mathématiques appliquées sont des maths liées à la résolution de problèmes tangibles. En maths appliquées, on ne travaille pas seul dans son coin, on est souvent en interaction avec d’autres disciplines telles que la biologie, la physique, l’ingénierie…Et le travail concret qui est réalisé peut aller de maths assez théoriques jusqu’à des aspects très informatiques liés aux calculs sur ordinateur.

A quel point êtes-vous devenu océanographe ?

Je ne suis pas un bon océanographe, mais je me suis suffisamment acclimaté pour comprendre ce que disent mes collègues quand on discute ensemble ! En tant que mathématicien appliqué, si tu veux avoir un minimum d’impact dans ce que tu fais, c’est indispensable de comprendre la physique et de ne pas travailler seul.

Tu peux toujours améliorer une méthode mathématique pour résoudre un problème, mais si tu ne connais pas telle ou telle contrainte de physique ou si tu ne discutes pas avec les océanographes, ton résultat peut être aberrant. Pour prendre un exemple très simple, il faut avoir en tête qu’une concentration, c’est toujours un nombre positif et non négatif. Si tu passes à côté de ça, ton résultat n’a aucune valeur pour les océanographes !

Sur quels sujets travaillez-vous, ainsi que votre équipe AIRSEA ?

Depuis les années 1990, l’équipe que je citais plus haut sur les mathématiques pour la physique et l’environnement, dont je fais partie, a grossi, puis s’est focalisée sur les aspects géophysiques : océanographie, météorologie, glaciologie, hydrologie.

Elle est devenue l’actuelle AIRSEA, spécialisée dans les mathématiques et le calcul scientifique appliqués aux écoulements océaniques et atmosphériques.

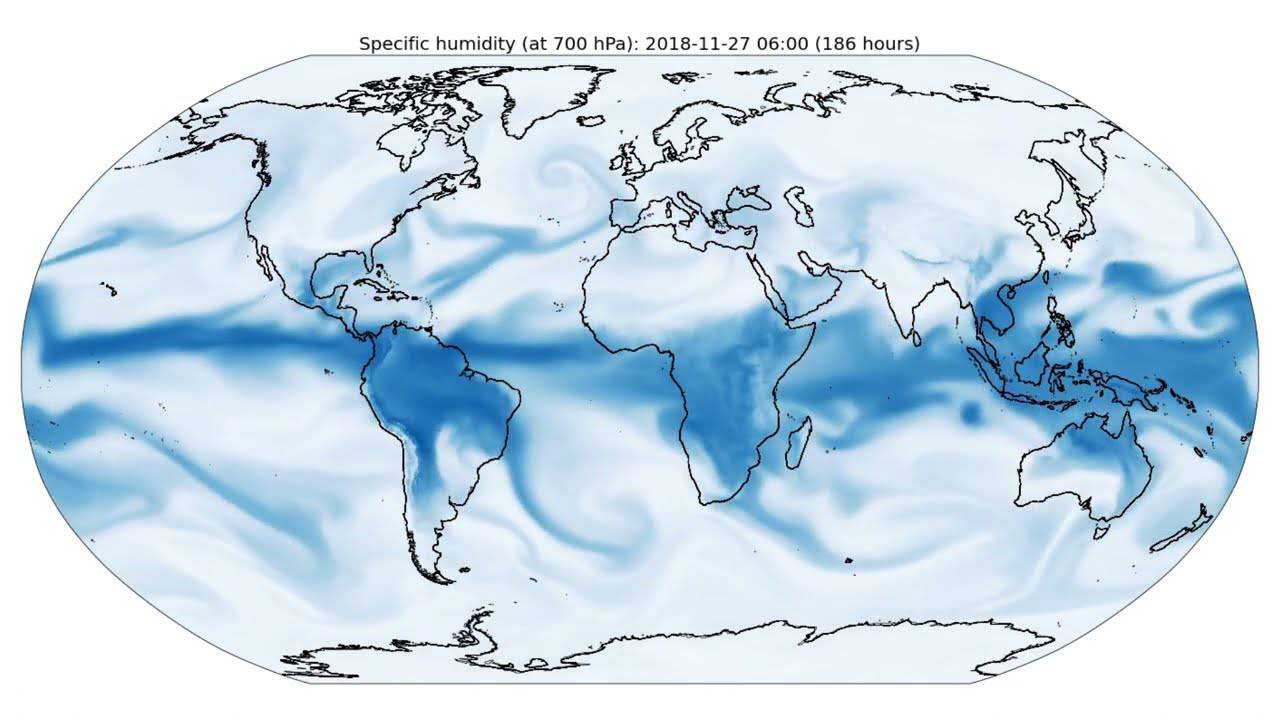

Au sein de cette équipe, j’ai développé des méthodes numériques pour les modèles d’océan, et fait de l’assimilation de données (“caler”’ le modèle grâce à des observations du monde réel). Ces dernières années, avec des collègues, je me suis surtout intéressé à la question du couplage entre l’océan et l’atmosphère, important notamment pour les modèles de climat. La physique est compliquée à l’interface de l’océan et de l’atmosphère, et il n’est pas simple de bien la représenter dans les modèles numériques, mais on améliore petit à petit les méthodes.

Quelles sources d’observations utilisez-vous ?

Il existe un grand nombre d’outils et de sources d’observation utilisés pour surveiller les océans, comme les satellites, les sondes, les bateaux commerciaux qui embarquent des appareils de mesure ou d’autres qui réalisent spécifiquement des campagnes en mer (mesure du courant, de la température et de la pression, du taux d’oxygène…).

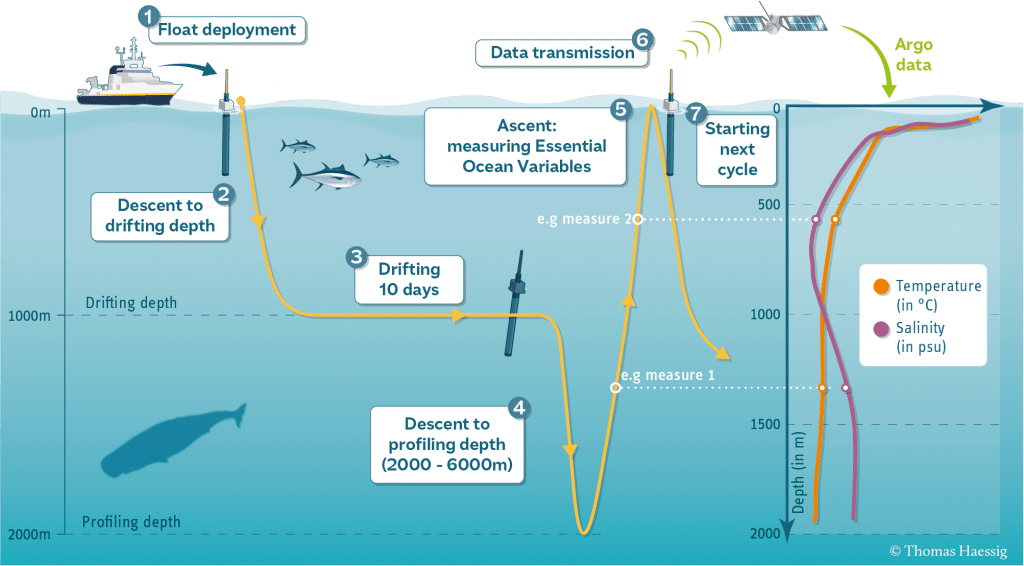

Depuis une vingtaine d’années, il existe le programme mondial ARGO, composé de 3 000 flotteurs sous-marins dont la flottabilité est calée à 1 000 mètres de profondeur. Ils dérivent à cette profondeur pendant 10 jours, puis plongent à 2000 mètres et remontent lentement à la surface en mesurant la température et la salinité, puis envoient leurs données aux satellites avant de replonger à 1000 mètres.

Schéma de transmission de données Argo

Et du côté de votre laboratoire, avec quels outils travaillez-vous ?

En général, on commence avec ce qu’on appelle un “modèle jouet”, un modèle simple qui tourne sur nos ordinateurs personnels et sur lequel on met au point nos méthodes. Éventuellement, on passe ensuite sur les ordinateurs de GRICAD, une infrastructure grenobloise de calcul intensif et de données. Il s’agit d’ordinateurs gérés par des ingénieurs qui servent à la communauté de recherche locale.

Serveurs du centre de calcul intensif grenoblois GRICAD (source photo)

A l’échelle supérieure, pour valider les nouvelles méthodes sur de vraies applications, on travaille en partenariat avec des collègues océanographes ou climatologues. Les calculs peuvent alors éventuellement nécessiter de très gros supercalculateurs comme ceux de l’Institut du développement et des ressources en informatique scientifique (IDRIS) à Paris. Il faut déposer une demande pour pouvoir calculer sur ces machines...

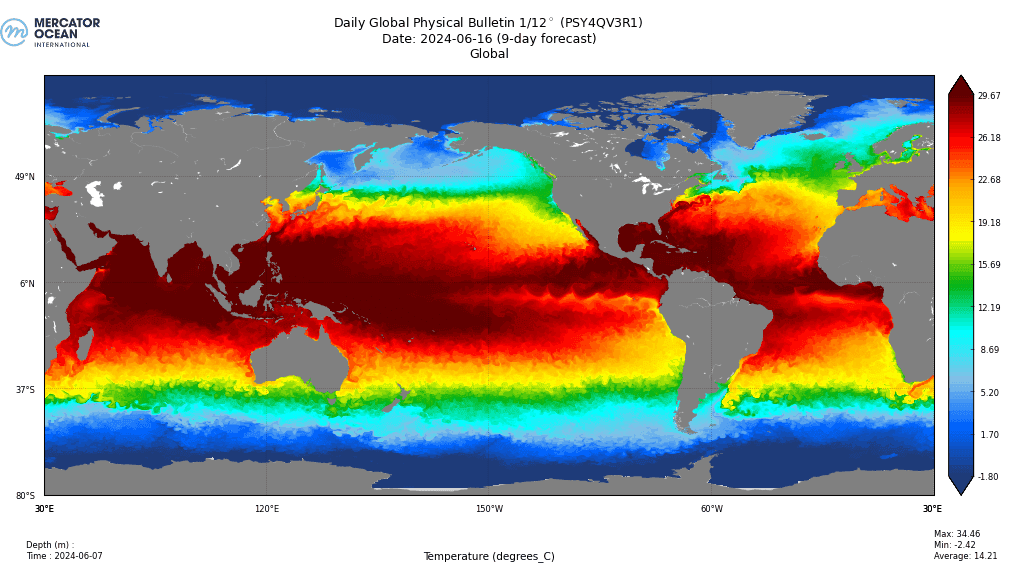

Bulletin physique global par Mercator Océan, pour le 16/06/2024 réalisé le 07/06 (source)

Entre l’idée, le premier modèle “jouet” et le moment où ce travail est injecté dans un modèle opérationnel à Météo France ou à Mercator océan, on a une échelle de temps de 10 à 15 ans (4).

Y a-t-il des spécificités dans votre travail, selon la zone que vous modélisez ?

Une équation est universelle, elle est bonne partout car ce sont des mathématiques, mais tel ou tel phénomène physique présent dans l’équation, lui, sera plus ou moins exacerbé selon la zone où on se trouve. Par exemple, une méthode qu’on met actuellement au point avec mes collègues climatologues marche bien en zone équatoriale, mais pas en zone arctique. A nous d’essayer de comprendre pourquoi la présence de glace rend notre méthode numérique moins performante. On en revient à ce qu’on disait : il ne faut pas travailler seul dans son coin, car il y a beaucoup trop de paramètres à prendre en compte.

Quels sont les défis d’un mathématicien en ce qui concerne la modélisation du climat ? Comment travailler dans l’incertitude ?

L’incertitude est très liée à la prévision. Si tu prétends fournir une prévision, alors il faut que tu arrives à quantifier son incertitude, à mettre une “barre d’erreur” dessus.

Problème : les modèles coûtent très cher. Comme on ne peut pas faire un million de simulations, on doit les choisir intelligemment. Pour ses prévisions quotidiennes, Météo France fait tourner son modèle 50 fois environ, en perturbant un peu l’état initial à chaque fois. Mais cet état est décrit par 109 valeurs . Cela veut dire qu’à un instant donné, on a 1 milliard d’informations différentes pour décrire l’état de l’atmosphère : comment choisir les 50 états initiaux de façon intelligente ? Des approches physiques et mathématiques permettent de cerner comment quantifier ces incertitudes. On a des collègues qui travaillent dessus dans l’équipe.

Un autre grand défi selon moi, est de réussir à faire passer cette idée d’incertitude aux publics et aux décideurs. Ces derniers ont des choix à faire, parfois dans l’urgence, comme par exemple savoir s’il faut évacuer ou pas une zone, et doivent intégrer cette notion de risque.

Une autre difficulté autour des modèles, c’est l’effet des petites échelles sur les plus grandes. Un modèle de l’Atlantique nord, par exemple, va avoir une résolution d’une dizaine de kilomètres (parce que cela coûterait trop cher d’aller à plus haute résolution) alors qu’il se passe des choses à une échelle plus petite. Il faut donc trouver des solutions, et notamment paramétriser, c’est-à-dire ajouter dans les équations un terme artificiel qui représente l’effet de ces petites échelles sur les plus grandes. Et c’est tout un art de trouver les bonnes paramétrisations pour mimer ces effets des petites échelles.

D'après une étude publiée dans la revue "Science" en novembre 2023, le programme d'intelligence artificielle GraphCast développé par DeepMind, filiale de Google, est plus efficace que les modèles de prévisions météo utilisés jusqu'ici. Que pensez-vous de la part croissante de l’intelligence artificielle et du traitement massif de données dans le marché de la météorologie ?

On commence à utiliser l’intelligence artificielle dans la modélisation numérique de la météo depuis 2 ou 3 ans. Mais l’IA ne pourrait pas exister sans les décennies de travaux humains au préalable. Si GraphCast fonctionne si bien, c’est parce que ses créateurs lui ont fait ingurgiter 40 ans de résultats de modèles numériques quotidiens à haute résolution, européens et américains.

L’outil est impressionnant de rapidité. Ce qui prenait plusieurs heures sur un supercalculateur à 100 millions d’euros prend maintenant quelques minutes sur un ordinateur personnel. Cette IA a encore des défauts d’après les météorologues, notamment sur les résultats à petite échelle mais j’imagine que cela sera bientôt amélioré.

On dit aussi que l’usage de cette IA ne coûte pas cher… mais c’est oublier un peu vite combien à coûté son apprentissage, sur les super-ordinateurs de Google, pendant des semaines et des semaines.

Pour ma part, j’entrevois deux risques : le premier risque est lié au changement climatique. On est en train d’apprendre à faire de la prévision météorologique sur des données passées alors que nous sommes actuellement dans une tendance de changement climatique. Si celle-ci n’est pas correctement représentée dans le modèle, il risque de ne pas bien fonctionner, notamment pour les événements extrêmes.

Le deuxième risque selon moi est institutionnel. Si l’IA se met à très bien marcher, certains chercheront à faire des économies, à couper des postes et les personnes qui avaient les compétences ne seront plus là pour contrôler l’IA. C’est déjà le cas à Météo France où on a observé une perte de l’ordre de 30% du personnel récemment.

Vous êtes engagé dans des actions de vulgarisation. En quoi est-ce important de partager vos connaissances ?

Je fais de la médiation scientifique depuis une dizaine d’années. Je pense que c’est lié au fait que je suis enseignant-chercheur. J’aime beaucoup enseigner, je me sens immédiatement utile, alors qu’en recherche tu peux avoir des grand moment de solitude…

Pour des classes de lycée ou pour les publics, je donne des exposés sur différents aspects (océanographie, climat, simulation numérique, maths dans la vie de tous les jours) (5).

Par ailleurs, je contribue au projet de “La Grange des maths” où nous proposons des maths tous publics, ludiques, les mains dans le cambouis [ndlr : lire sa présentation du projet, avec Christine Kazantsev]. Depuis quelques années, plusieurs collègues de notre équipe ont créé des mallettes pédagogiques pour les collégiens (“La Grange Vadrouille”) et les élèves de primaire (“La Grange d'École”). Elles ont déjà été utilisées par 40 000 élèves sur l’Académie de Grenoble et ont reçu le prix Jacqueline Ferrand 2020, attribué par la Société Mathématique de France.

Test des mallettes par l’équipe de M@ths’n Co

Chaque valise propose une vingtaine d’activités rattachées au programme, qui sont ludiques et non notées. Les élèves passent librement d’une activité à une autre. Il y a un livret pour l’enseignant, qui présente chaque activité, sa solution, les notions de maths auxquelles elle est rattachée, à quoi cela peut servir dans la vie de tous les jours. On a remarqué que ces mallettes étaient notamment prisées par les professeurs-documentalistes dans les CDI !

La Grange des maths propose également un escape game ``Mission exoplanètes’’, un stand au Parvis des sciences pour la Fête de la science et une journée grand public annuelle à Varces-Allières-et-Risset appelée “Maths à l’Oriel”.

Les maths souffrent-elles encore d’une mauvaise image auprès des publics ?

J’avoue que je suis souvent énervé lorsque j’entends quelqu’un dire “je ne comprends rien aux maths” d’une manière snob, comme s’il fallait se vanter de cette méconnaissance, alors que quand on s’y penche un peu, tout le monde peut comprendre. Par ailleurs, beaucoup de gens racontent n’importe quoi ou se trompent sur des choses évidentes, dans les médias par exemple… En revanche, les stands de la Grange des maths marchent à chaque fois. C’est bien la marque d’un intérêt des publics, malgré tout !

En quoi votre rôle d’ambassadeur de la Fête de la science est-il important pour vous ?

Je souhaite participer à désacraliser les mathématiques et les sciences, partager des connaissances aux publics et montrer que les chercheurs et les chercheuses ne sont pas hors-sol, qu’ils sont des gens comme les autres. Plus on a de connaissances, plus on a d’esprit critique, de recul, d’où mon souhait de partage des connaissances notamment autour du changement climatique.

Propos recueillis par Marion Sabourdy

Crédits photos

Image principale : © Inria / MOISE - CNRS / LEGI / Photo N. Hairon

Notes

- L’Ifremer est l’Institut français de recherche dédié à la connaissance de l’océan qui fête ses 40 ans cette année

- D’un montant de 15 000 €, le Prix Christian Le Provost fondé par le CNRS, l’IFREMER, le CNES, l’IRD, le SHOM, le Cluster Maritime France (CMF), le Conseil départemental des Côtes-d’Armor et la ville de Plérin, en hommage au chercheur, récompense l’autrice ou l’auteur de recherches conduites dans un laboratoire français pour des travaux remarquables en océanographie physique et biogéochimique

- La plateforme Coriolis est maintenant située sur le campus de Saint-Martin-d’Hères

- Arpege est le modèle de Météo France, qui englobe un territoire légèrement plus grand que la France et propose quelques jours de prévision. Il est nourri aux frontières par les prévisions du Centre européen pour les prévisions météorologiques à moyen terme (ECMWF), situé à Reading (Grande-Bretagne), Bonn (Allemagne) et Bologne (Italie). L’équipe derrière Mercator océan est basée à Toulouse et le modèle est labellisé au niveau européen. Il propose une carte de prévision de l’océan pour les 3 semaines à venir dont la température, le courant, la salinité…

- Voir la vidéo de la conférence “A quoi servent les maths” donnée en 2016 à la Bibliothèque Kateb Yacine de Grenoble

Ressources

- Ces océans qu’on modélise, Antoine Rousseau, Eric Blayo, Martin Parisot, Arthur Vidard, Maëlle Nodet, et Julien Salomon, Binaire, 2019

- Quand les big data font la pluie et le beau temps, Eric Blayo, The Conversation, 2018

- Le climat en équations, Eric Blayo, Interstices, 2013

- De la prévision météo à la prévision environnementale, Françoise Breton, Eric Blayo, François-Xavier Le Dimet, Inria, 2012

- Assimilation de données et climat, Olivier Talagrand, Eric Blayo et Jacques Verron, dans l’ouvrage Le climat à découvert. Outils et méthodes en recherche climatique, CNRS Editions, 2011

- La prévision en environnement : un enjeu pour les mathématiques appliquées, Inria, 2011

Article rédigé dans le cadre de la Fête de la science 2024